‘대필 논란’ 불거진 챗GPT… 피싱 메일 등 범죄 악용 시도도

페이지 정보

작성자 cfpa 댓글 0건 조회 620회 작성일 23-02-16 08:51본문

출처 :https://news.kmib.co.kr/article/view.asp?arcid=0924287523&code=11151400&cp=nv

챗GPT와 같은 초거대 생성형 인공지능(AI)이 일상으로 진입하면서 부작용을 걱정하는 목소리가 커지고 있다. 이미 학계, 교육계에서는 ‘대필’ 논란이 불거졌다. 저작권 분쟁, 혐오 표현뿐 아니라 범죄에 악용되는 ‘무기’가 될 수 있다는 우려에 직면했다.

언어 생성형 AI는 질문과 답을 하는 과정에서 사람과 비슷한 언어로 결과물을 만들어낸다. 표절이나 저작권 침해를 양산하는 주범이라는 꼬리표가 따라붙는 이유다. 한 일본인은 네이버의 AI 번역기 파파고로 한국 웹툰을 일본어로 번역했고, 관련 업계의 번역 신인상을 수상했다는 사실이 최근에 밝혀지기도 했다. 한국의 한 국제학교에서는 일부 학생이 챗GPT를 활용해 영문 에세이를 작성해 제출했다가 전원 0점 처리됐다. IT업계 관계자는 15일 “생성형 AI가 일상화할수록 콘텐츠에 대한 신뢰성이 떨어질 것이다. 표절 여부 등을 검증하는 데 사회적 자원도 더 많이 필요할 것”이라고 말했다.

생성형 AI가 범죄 등에 악용될 수도 있다. 챗GPT의 경우 우회적 질문으로 답을 유도하면 범죄에 필요한 피싱 이메일까지 작성해준다. 과거 해커가 보내는 피싱 이메일은 “친애하는 A씨”와 같이 일상에서 잘 쓰지 않는 문구를 담고 있어 ‘스팸 메일’로 자동 분류됐다. 반면 챗GPT로 만든 자연스러운 한국어 피싱 이메일의 경우 필터링이 제대로 작동하지 않아 피해자가 빠르게 늘 수밖에 없다. 고도화한 해킹 도구를 스스로 만들지 못하는 사람도 챗GPT를 활용해 쉽게 악성코드를 만들 수 있다. 실제로 이스라엘 사이버보안업체 체크포인트는 지난달에 해커가 활동하는 사이버 포럼 등의 공간에서 챗GPT가 악성코드, 피싱 메일 등의 해킹 도구를 개발하는 데 활용됐다고 발표했다.

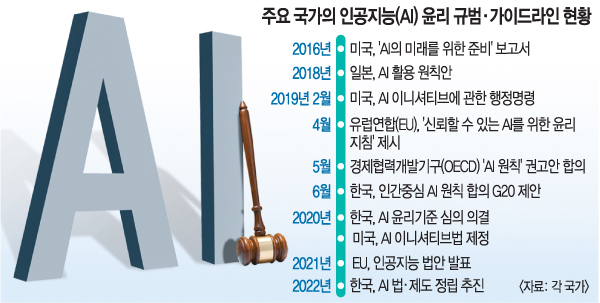

이 때문에 생성형 AI를 ‘나쁜 의도’로 사용하는 걸 막는 ‘장치’가 필요하다는 지적이 나온다. 미라 무라티 오픈AI 최고기술책임자(CTO)는 “챗GPT는 사실을 꾸며내고, 나쁜 의도를 가진 이용자들에게 얼마든지 악용될 수 있다. 개발자 홀로 이 문제를 해결할 수 없다. 정부, 철학자 등 모두가 참여해 규제를 논의해야 한다”고 말했다.

전성필 기자 feel@kmib.co.kr

[출처] - 국민일보

[원본링크] - https://news.kmib.co.kr/article/view.asp?arcid=0924287523&code=11151400&cp=nv